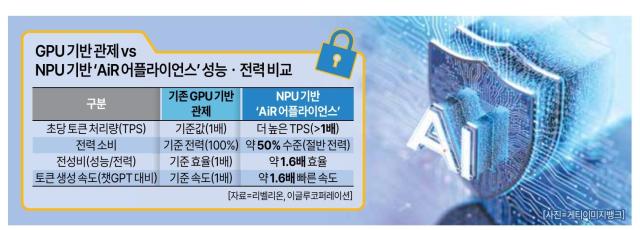

16일 이글루코퍼레이션과 AI 반도체 스타트업 리벨리온이 공동 개발한 NPU 기반 ‘AiR 어플라이언스’(특정 기능에 맞춰 만든 전용 장비) 시제품 테스트 결과에 따르면, 보안 특화 언어모델(LLM)을 돌렸을 때 기존 GPU 서버보다 초당 토큰 처리량(TPS·AI가 1초에 처리하는 글자 조각 수)은 더 높고, 전력 소비는 약 절반 수준에 그쳤다.

전력 대비 성능 비율(전성비)은 GPU보다 약 1.6배 개선됐고, 주요 소형언어모델(sLLM) 기준으로는 오픈AI의 ‘챗GPT’보다 약 1.6배 빠른 토큰 생성 속도를 달성할 수 있는 것으로 나타났다.

이 결과는 ‘생성형 AI 보안에는 고가의 GPU·해외 클라우드가 필수’라는 전제를 국산 NPU가 처음으로 흔들기 시작했다는 점에서 의미가 크다.

그간 보안 분야에서 생성형 AI를 도입하려면 선택지는 사실상 두 가지뿐이었다. 해외 클라우드 기반 LLM을 그대로 빌려 쓰거나, 자사 전산실에 GPU 서버를 직접 들여와 모델을 띄우는 방법이다.

클라우드 기반 방식의 경우, 침해사고 로그(기록)‧내부 시스템 정보 등 민감한 데이터를 외부 클라우드로 보내야 한다는 부담이 컸다. GPU 방식은 장비 가격과 전기요금, 냉각·공간 비용 등을 감안하면 수요층이 대형 금융사·대기업 정도로 한정됐다. 이번에 실측 결과가 나온 NPU 어플라이언스는 이를 해결할 실질적 대안이 될 수 있다.

전문가들은 특히 이번 결과가 국산 NPU·보안 소프트웨어 조합을 통해 ‘전산실 안에 들어오는 형태’로 구현했다는 점을 높게 평가하고 있다. 정부가 추진 중인 AI 반도체·보안 기술 자립 기조와 맞물려 향후 정책·공공 사업에서 추가적인 의미 확보도 가능할 것으로 보고 있다.

아직까진 시제품·초기 도입 단계에 불과한 만큼, 다양한 해결 과제도 상존한다. 실제 사업 현장에서는 AI 모델의 탐지 정확도, 오탐·미탐(탐지 실패) 비율, 장애 대응 등을 포함한 장기간 운영 데이터가 쌓여야만 본격적인 평가가 가능하다는 지적도 나온다. 생태계 측면에서도 글로벌 GPU 진영에 비해 국산 NPU를 둘러싼 개발 도구와 인력 층은 아직 부족한 실정이다.

한 보안업계 관계자는 “제품이 본격 상용화 단계에 올라서면 생성형 AI 보안관제의 화두는 ‘GPU를 감당할 수 있느냐’에서 ‘우리 SOC에 AI 박스 한 대를 어떻게 붙일 거냐’로 바뀔 것”이라며 “그 이후 공공·중견 고객사 도입 실적이 얼마나 빠르게 쌓이느냐에 따라 국산 NPU의 ‘보안 인프라’로서 입지도 함께 결정될 것”이라고 말했다.

©'5개국어 글로벌 경제신문' 아주경제. 무단전재·재배포 금지

![[르포] 중력 6배에 짓눌려 기절 직전…전투기 조종사 비행환경 적응훈련(영상)](https://image.ajunews.com/content/image/2024/02/29/20240229181518601151_258_161.jpg)