카카오가 국내 공개 모델 중 최고 성능의 경량 멀티모달(텍스트·이미지·음성·영상 등 동시 처리) 언어모델과 국내 최초의 MoE(Mixture of Experts) 모델을 오픈소스(개방형)로 공개했다.

카카오는 공개된 모델이 '카나나-1.5-v-3b'와 '카나나-1.5-15.7b-a3b'라고 24일 밝혔다.

해당 모델은 글로벌 인공지능(AI) 플랫폼 허깅페이스를 통해 제공된다.

카카오는 지난 5월 카카나-1.5 4종을 공개했는데 두 달만에 추가 모델을 오픈소스로 공개했다. 정부가 추진하는 '독자 AI 파운데이션 모델 프로젝트'에 참여한 카카오는 자체 모델 개발 역량 등을 토대로 전 국민의 AI 접근성을 높인다는 방침이다.

카나나-1.5-v-3b는 이미지 정보 이해 및 지시 이행 능력을 갖춘 경량 멀티모달 언어모델로, 카나나 1.5를 기반으로 한다. 이미지 정보를 활용한 질문 이해 및 지시 이행 능력이 강점이다.

특히 한국어·영어 기반 이미지 이해 능력에서 뛰어난 성능을 보이며, 카카오는 이 모델의 수준이 GPT-4o에 필적한다고 평가했다.

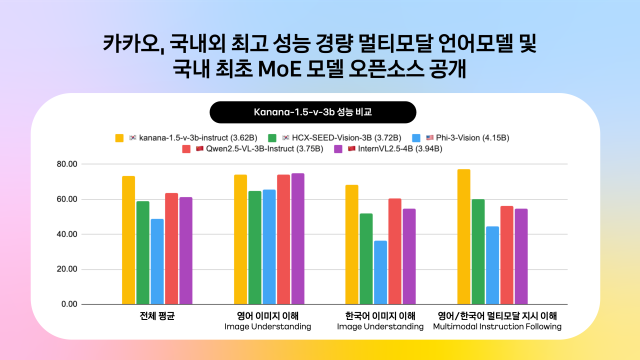

한국어 벤치마크에서는 유사 사이즈의 국내외 공개 모델 중 최고 성능을 기록했고, 영어 벤치마크에서도 해외 오픈소스 모델과 유사한 수준의 결과를 나타냈다. 지시 이행 성능의 경우, 국내 공개된 유사 규모의 멀티모달 모델 대비 128%에 달하는 성능을 보였다.

이 모델은 △이미지 및 문자 인식 △동화·시 창작 △문화유산 및 관광지 인식 △도표 이해 △수학 문제풀이 등 다양한 분야에 유연하게 활용 가능하다.

함께 공개된 카나나-1.5-15.7b-a3b는 MoE 구조를 채택하고 있다. 기존 모델이 모든 파라미터를 동시에 연산하는 것과 달리, MoE는 입력 데이터의 특성에 따라 최적화된 일부 전문가 모델(Experts)만을 활성화하는 방식이다.

이를 통해 컴퓨팅 자원을 효율적으로 활용하고, 처리 비용을 줄이는 데 유리하다. MoE는 현재 글로벌 AI 업계에서 주요 개발 트렌드로 자리잡고 있다.

카카오는 이번 오픈소스 공개를 통해 국내 AI 모델 생태계의 발전과 기술 자립을 동시에 도모할 계획이다.

©'5개국어 글로벌 경제신문' 아주경제. 무단전재·재배포 금지

![[르포] 중력 6배에 짓눌려 기절 직전…전투기 조종사 비행환경 적응훈련(영상)](https://image.ajunews.com/content/image/2024/02/29/20240229181518601151_258_161.jpg)